AI智能客服系统的价值不仅在于技术实现,更取决于其实际服务能力。许多团队在完成系统搭建后,因缺乏科学的验证体系,难以量化真实效果。本文从业务效能、用户体验、运维质量三大维度,拆解验证系统效果的10项关键指标,为效果评估与优化提供清晰路径。

一、核心效能指标:检验问题解决能力

1.意图识别准确率

定义:系统正确理解用户诉求的比例,直接影响应答方向。

测量方式:抽取历史对话样本,对比AI判断结果与人工标注的真实意图。

优化方向:当准确率低于85%时,需补充特定场景的标注数据或优化实体抽取规则。

2.问题解决率

定义:用户咨询无需人工介入即可闭环的比例。

测量方式:统计会话结束时用户明确表达“已解决”或未转人工的比例。

优化方向:针对高转人工率的问题类型(如售后纠纷),优化知识库应答逻辑或补充多轮对话脚本。

3.多轮对话效率

定义:用户平均需要几次交互完成问题解决。

测量方式:计算会话轮次的中位数,理想值控制在3-5轮内。

优化方向:通过预判用户需求(如主动提供订单号输入入口),减少无效追问。

二、用户体验指标:衡量服务满意度

1.响应速度

定义:从用户提问到系统返回首条应答的时间。

测量方式:监测接口响应延迟,建议90%的请求在1秒内完成。

优化方向:压缩模型推理耗时(如使用轻量化模型)或优化知识库检索算法。

2.对话流畅度

定义:对话逻辑连贯性及上下文理解能力。

测量方式:人工抽检对话记录,评估是否出现答非所问、重复提问等问题。

优化方向:引入上下文缓存机制,或增加意图纠错模块(如用户反问时重新识别意图)。

3.用户满意度(CSAT)

定义:用户对单次服务的评分。

测量方式:在对话结束时推送评分弹窗,收集1-5星评价。

优化方向:针对低分会话分析原因(如应答机械、未解决核心问题),优化应答话术或知识库结构。

三、运维质量指标:保障系统稳定性

1.系统可用性

定义:服务正常运转时间占总监测时间的比例。

测量方式:通过自动化脚本模拟请求,监测接口可用性,目标值≥99.9%。

优化方向:建立负载均衡机制,避免高并发时段服务崩溃。

2.人工干预率

定义:需要人工主动接管会话的比例。

测量方式:统计因置信度不足、用户请求转接导致的转人工次数。

优化方向:设置动态阈值(如夜间降低转接标准),结合会话关键节点设计“软转接”提示。

四、持续优化指标:驱动系统迭代

1.知识库更新效率

定义:从业务规则变更到AI系统同步更新的耗时。

测量方式:记录政策调整、新品上线等事件的知识库更新周期。

优化方向:建立知识库版本管理工具,支持快速回滚与多环境同步。

2.异常问题闭环率

定义:监测到的系统缺陷在指定周期内修复的比例。

测量方式:跟踪问题工单的解决进度,建议72小时内闭环率>90%。

优化方向:构建“监测-归因-修复”自动化流程,例如通过日志分析定位高频错误代码。

总结:

验证AI智能客服系统的效果需避免“唯技术论”,应从业务目标出发选择指标组合。例如,售前咨询场景优先考核转化率,而售后场景侧重问题解决率与用户情绪安抚效果。建议企业每月生成效果分析报告,结合A/B测试对比不同策略的指标变化,最终形成“验证-优化-再验证”的持续改进闭环。

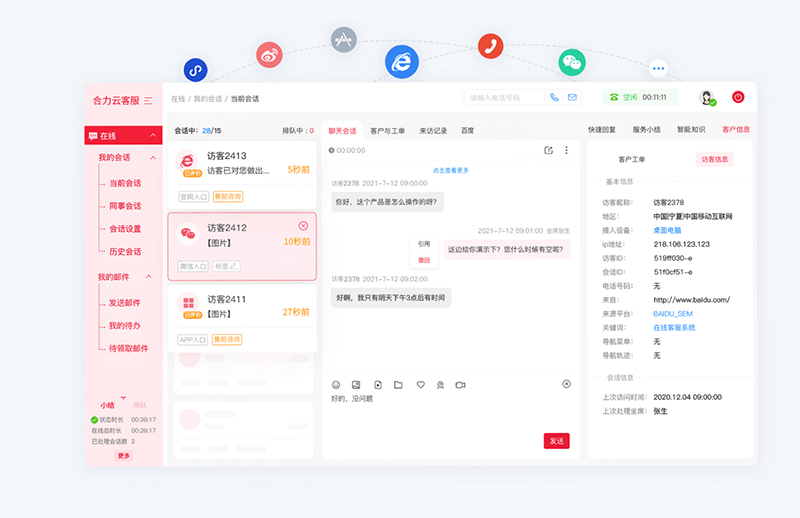

合力亿捷云客服集智能呼叫中心+AI智能客服+AI智能客服机器人+CRM+智慧工单于一体,系统低成本灵活搭建,支持全渠道接入,提供营销版,在线版,经典版3大版本,满足企业不同业务需求。